Klasyczna architektura PC. Główne cechy architektury współczesnych komputerów

Pomimo tego, że nowoczesne modele komputerów są reprezentowane na rynku przez szeroką gamę marek, są one gromadzone w niewielkiej liczbie architektur. Jaki jest powód? Jaka jest specyficzna architektura współczesnych komputerów? Jakie komponenty oprogramowania i sprzętu je tworzą?

Definicja architektury

Czym jest architektura PC? W tym dość szerokim pojęciu zwyczajowo rozumieć zbiór logicznych zasad montażu systemu komputerowego, a także charakterystyczne cechy wprowadzanych do niego rozwiązań technologicznych. Architektura PC może być narzędziem standaryzacji. Oznacza to, że komputery w nim zawarte mogą być montowane zgodnie z ustalonymi schematami i podejściami technologicznymi. Łączenie pewnych koncepcji w jedną architekturę ułatwia promowanie modelu PC na rynku, pozwala tworzyć programy opracowane przez różne marki, ale gwarantowane, że będą odpowiednie. Zunifikowana architektura komputerów umożliwia producentom komputerów aktywną współpracę w celu udoskonalenia niektórych komponentów technologii komputerowej.

Pod tym terminem można rozumieć zestaw podejść do montażu komputerów lub jego poszczególnych komponentów, przyjętych na poziomie konkretnej marki. W tym sensie architektura, która jest rozwijana przez producenta, jest jego własnością intelektualną i jest używana tylko przez nią, może działać jako konkurencyjne narzędzie na rynku. Ale nawet w tym przypadku decyzje różnych marek można czasem zaklasyfikować do ogólnej koncepcji, łącząc kluczowe kryteria charakteryzujące komputery różnych modeli.

Termin "informatyka komputerowa" jako gałąź wiedzy można rozumieć na różne sposoby. Pierwsza wersja interpretacji obejmuje interpretację rozważanej koncepcji jako kryterium standaryzacji. Zgodnie z inną interpretacją architektura jest raczej kategorią, która pozwala jednej marce producenta stać się konkurencyjną z innymi.

Najciekawszym aspektem jest korelacja historii i architektury komputera. W szczególności jest to pojawienie się klasycznych układów logicznych komputerów. Rozważ jego funkcje.

Klasyczna architektura komputerowa

Kluczowe zasady, według których projekt komputerów osobistych miał być zgodny z pewnym logicznym schematem, zaproponował wybitny matematyk John von Neumann. Jego pomysły zostały wdrożone przez twórców komputerów PC z pierwszych dwóch pokoleń. Koncepcja opracowana przez Johna von Neumanna to klasyczna architektura PC. Jakie są jego funkcje? Zakłada się, że komputer powinien składać się z następujących głównych elementów:

- blok arytmetyczno-logiczny;

- urządzenia sterujące;

- blok pamięci zewnętrznej;

- blok pamięci RAM;

- urządzenia przeznaczone do wprowadzania i wyprowadzania informacji.

W ramach tego schematu interakcja komponentów technologicznych powinna być realizowana w określonej kolejności. Najpierw dane z programu komputerowego, które można wprowadzić za pomocą zewnętrznego urządzenia, trafiają do pamięci komputera. Następnie urządzenie sterujące odczytuje informacje z pamięci komputera, a następnie wysyła je do wykonania. W tym procesie, jeśli to konieczne, użyj pozostałych komponentów komputera.

Architektura nowoczesnych komputerów

Zastanów się, jakie są główne cechy architektury współczesnych komputerów. To trochę różni się od koncepcji, którą studiowaliśmy powyżej, ale na wiele sposobów ją kontynuuje. Kluczową cechą najnowszej generacji komputerów jest arytmetyczna, logiczna jednostka oraz fakt, że urządzenia sterujące są połączone w jeden komponent technologiczny - procesor. Pod wieloma względami było to możliwe dzięki pojawieniu się chipów i ich dalszej poprawie, co umożliwiło dopasowanie szerokiego zakresu funkcji do stosunkowo niewielkiej części komputerowej.

Architektura nowoczesnego komputera charakteryzuje się również obecnością kontrolerów. Pojawiły się one w wyniku rewizji koncepcji, w której procesor miał pełnić funkcję wymiany danych z urządzeniami zewnętrznymi. Ze względu na możliwości układów scalonych, które pojawiły się, producenci komputerów postanowili oddzielić odpowiedni komponent funkcjonalny od procesora. Tak więc istniały różne kanały wymiany, a także układy peryferyjne, które zaczęto nazywać kontrolerami. Odpowiednie komponenty sprzętowe na nowoczesnych komputerach mogą na przykład kontrolować działanie dysków.

Architektura urządzeń i komputerów o nowoczesnym wzornictwie obejmuje korzystanie z autobusu. Jego głównym celem jest zapewnienie komunikacji pomiędzy różnymi elementami sprzętowymi komputera. Jego struktura może zakładać obecność wyspecjalizowanych modułów odpowiedzialnych za daną funkcję.

Architektura IBM

IBM opracował architekturę komputerów PC, która stała się jednym ze światowych standardów. Jego charakterystyczną cechą jest otwartość. Oznacza to, że komputer w nim przestaje być produktem końcowym marki. IBM nie jest monopolistą rynku, choć jest jednym z pionierów w tworzeniu odpowiedniej architektury.

Użytkownik lub firma montująca komputery PC na platformie IBM może samodzielnie określić, które komponenty zostaną uwzględnione w strukturze komputera. Możliwe jest również zastąpienie jednego lub drugiego elementu elektronicznego bardziej zaawansowanym. Szybki rozwój technologii komputerowej pozwolił wdrożyć zasadę otwartej architektury PC.

Funkcje oprogramowania dla komputerów IBM Architecture Computers

Ważnym kryterium przydziału komputera na platformę IBM jest jego kompatybilność z różnymi systemami operacyjnymi. I to również wskazuje na otwartość tego typu architektury. Komputery związane z platformą IBM mogą być zarządzane przez system Windows, Linux w wielu modyfikacjach, a także inne systemy operacyjne, które są kompatybilne ze sprzętowymi komponentami komputera danej architektury. Oprócz oprogramowania znanych marek, różne oprogramowanie do tworzenia treści może być zainstalowane na platformie IBM, której wydanie i instalacja zwykle nie wymaga koordynacji z producentami sprzętu.

Wśród komponentów oprogramowania, które znajdują się w prawie każdym komputerze na platformie IBM, podstawowy system wejścia i wyjścia, zwany także BIOS. Został zaprojektowany w celu zapewnienia wdrożenia podstawowych funkcji sprzętowych komputera, bez względu na rodzaj zainstalowanego na nim systemu operacyjnego. I to jest kolejna, w gruncie rzeczy, oznaka otwartości omawianej architektury: producenci systemów BIOS są tolerancyjni wobec producentów systemów operacyjnych i innych programów. W rzeczywistości fakt, że BIOS może być produkowany przez różne marki, jest również kryterium otwartości. Funkcjonalnie systemy BIOS różnych programistów są blisko.

Jeśli komputer nie ma zainstalowanego systemu BIOS, jego działanie jest prawie niemożliwe. Nie ma znaczenia, czy system operacyjny jest zainstalowany na komputerze - konieczne jest zapewnienie interakcji pomiędzy sprzętowymi komponentami komputera, a może on zostać wdrożony tylko przy użyciu systemu BIOS. Ponowne instalowanie systemu BIOS na komputerze wymaga specjalnych narzędzi programowych i sprzętowych, w przeciwieństwie do instalowania systemu operacyjnego lub innego oprogramowania w nim uruchomionego. Ta funkcja systemu BIOS jest zdeterminowana faktem, że musi być chroniona przed wirusami komputerowymi.

Korzystając z systemu BIOS, użytkownik może sterować elementami sprzętowymi komputera, ujawniając określone ustawienia. Jest to również jeden z aspektów otwartości platformy. W niektórych przypadkach praca z odpowiednimi ustawieniami pozwala zapewnić zauważalne przyspieszenie komputera, bardziej stabilną pracę poszczególnych komponentów sprzętowych.

BIOS w wielu komputerach jest uzupełniony powłoką UEFI, jak uważa wielu specjalistów IT, jest to bardzo przydatne i funkcjonalne rozwiązanie programowe. Jednak podstawowy cel UEFI nie różni się zasadniczo od tego, co jest typowe dla BIOS-u. W rzeczywistości jest to ten sam system, ale interfejs w nim jest nieco bliższy temu, co jest typowe dla systemu operacyjnego komputera.

Najważniejszym typem oprogramowania dla komputerów jest sterownik. Konieczne jest prawidłowe działanie komponentu sprzętowego zainstalowanego w komputerze. Sterowniki są zwykle produkowane przez producentów sprzętu komputerowego. Jednak odpowiedni typ oprogramowania, który jest kompatybilny z jednym systemem operacyjnym, takim jak Windows, zwykle nie jest odpowiedni dla innych systemów operacyjnych. Dlatego też często użytkownik musi wybrać sterowniki, które są kompatybilne z określonymi typami oprogramowania komputerowego. W tym sensie platforma IBM nie jest wystarczająco wystandaryzowana. Może się zdarzyć, że urządzenie działające doskonale w systemie operacyjnym Windows nie będzie mogło działać pod Linuksem, ponieważ użytkownik nie może znaleźć potrzebnego sterownika, lub ponieważ producent komponentu sprzętowego po prostu nie miał czasu na wydanie odpowiedniego oprogramowania.

Ważne jest, aby rozwiązanie, które należy uwzględnić w strukturze komputera, było kompatybilne nie tylko z określoną architekturą, ale także z innymi elementami technologicznymi komputera. Jakie komponenty można zmienić na nowoczesnych komputerach? Wśród kluczowych: płyta główna, procesor, pamięć RAM, karta graficzna, dyski twarde. Przyjrzyjmy się szczegółom każdego z komponentów bardziej szczegółowo, określmy, od czego zależy ich kompatybilność z innymi elementami sprzętowymi, a także dowiedz się, w jaki sposób zasada otwartej architektury PC może być w praktyce najskuteczniej zaimplementowana.

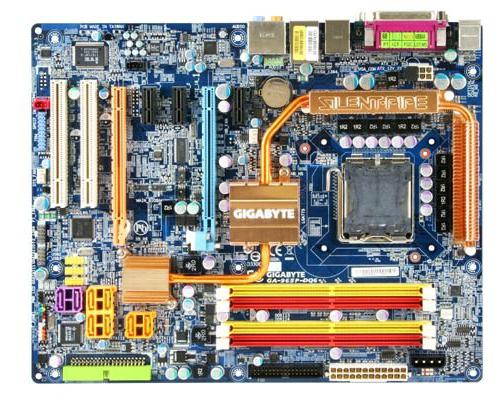

Płyta główna

Jednym z kluczowych elementów nowoczesnego komputera jest płyta główna lub płyta systemowa. Zawiera kontrolery, magistrale, mosty i inne elementy, które pozwalają łączyć różne elementy sprzętowe. Dzięki temu w rzeczywistości zaimplementowano nowoczesną architekturę PC. Płyta główna umożliwia efektywną dystrybucję funkcji komputera na różnych urządzeniach. Ten składnik umieszcza na sobie większość pozostałych, mianowicie procesor, kartę graficzną, pamięć RAM, dyski twarde itp. BIOS, najważniejszy komponent oprogramowania komputera, jest w większości przypadków zapisany w jednym z układów na płycie głównej. Ważne jest, aby odpowiednie elementy nie zostały uszkodzone.

Zastępując płytę główną lub wybierając odpowiedni model w procesie montażu PC, musisz upewnić się, że nowy model będzie kompatybilny z innymi komponentami sprzętowymi. Są więc płyty główne obsługujące procesory Intela, ale są też takie, na których można instalować tylko układy AMD. Bardzo ważne jest, aby nowa płyta obsługiwała istniejące moduły pamięci. Jeśli chodzi o kartę graficzną i dyski twarde, zwykle nie ma problemów z powodu wystarczająco wysokiego poziomu standaryzacji na odpowiednich rynkach. Niepożądane jest jednak to, że nowa płyta główna i te elementy różnią się zbytnio pod względem możliwości wytwarzania. W przeciwnym razie mniej produktywny element spowolni cały system.

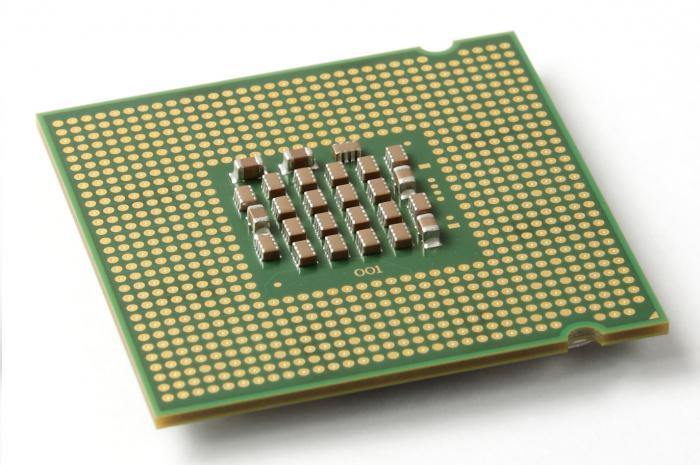

Procesor

Głównym chipem nowoczesnego komputera jest procesor. Otwarta architektura PC pozwala, według uznania użytkownika, zainstalować na komputerze wydajniejszy, wydajny procesor technologiczny. Ta możliwość może jednak oznaczać szereg ograniczeń. Zasadniczo nie można wymienić procesora Intel na AMD bez wymiany innego komponentu - płyty głównej. Problematyczne jest również instalowanie jednego układu zamiast innego tej samej marki, ale należącego do innego rodzaju linii technologicznej.

Instalując mocniejszy procesor na komputerze, musisz upewnić się, że pamięć RAM, dyski twarde i karta graficzna nie są daleko za nim technologicznie. W przeciwnym razie, jak już wspomniano powyżej, wymiana chipa może nie przynieść oczekiwanego rezultatu - komputer nie będzie działał szybciej. Głównymi wskaźnikami wydajności procesora są częstotliwość zegara, liczba rdzeni, wielkość pamięci podręcznej. Im większe, tym szybszy układ działa.

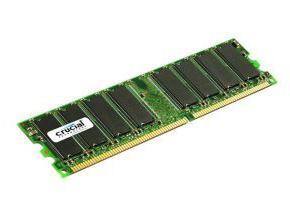

RAM

Ten składnik ma również bezpośredni wpływ na wydajność komputera. Podstawowe funkcje pamięci RAM są takie same, jak w przypadku typowych komputery na początku pokolenia. W tym sensie pamięć RAM jest klasycznym komponentem sprzętowym. Podkreśla to jednak jego znaczenie: do tej pory producenci komputerów nie wymyślili godnej alternatywy.

Głównym kryterium wydajności pamięci jest jej objętość. Im więcej, tym szybciej działa komputer. Ponadto moduły PC mają częstotliwość taktowania, podobnie jak procesor. Im wyższy, tym bardziej wydajny jest komputer. Wymaga się wymiany pamięci RAM, upewniając się, że nowe moduły są kompatybilne z płytą główną.

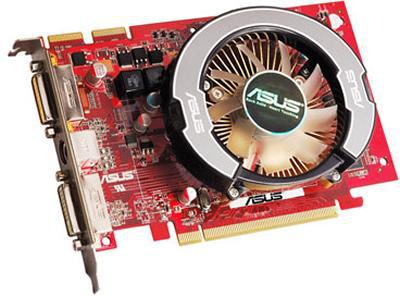

Karta wideo

Zasady architektury PC pierwszej serii nie oznaczały oddzielenia karty wideo na osobny komponent. Oznacza to, że to rozwiązanie sprzętowe jest również jednym z kryteriów klasyfikacji komputera do współczesnych pokoleń. Karta graficzna jest odpowiedzialna za przetwarzanie grafiki komputerowej - jednej z najbardziej złożonych typy danych wymagające układów scalonych o wysokiej wydajności.

Ten komponent sprzętowy powinien zostać zastąpiony przez korelację jego głównych cech z mocą i poziomem technologicznym procesora, pamięci i płyty głównej. Wzór tutaj jest taki sam, jak wspomniano powyżej: niepożądane jest, że odpowiednie elementy komputera różnią się znacznie pod względem wydajności. W przypadku karty wideo kluczowymi kryteriami są wielkość pamięci wewnętrznej oraz częstotliwość zegara głównego układu.

Zdarza się, że moduł odpowiedzialny za przetwarzanie grafiki komputerowej jest wbudowany w procesor. I nie można tego uznać za oznakę, że komputer jest przestarzały, wręcz przeciwnie, podobny schemat jest obserwowany na wielu nowoczesnych komputerach. Ta koncepcja jest najbardziej popularna wśród producentów notebooków. Jest to całkiem logiczne: marki muszą zapewnić zwartość tego typu komputerów. Karta wideo jest dość obszernym komponentem sprzętowym, jej rozmiar jest najczęściej zauważalnie większy niż procesor lub moduł pamięci.

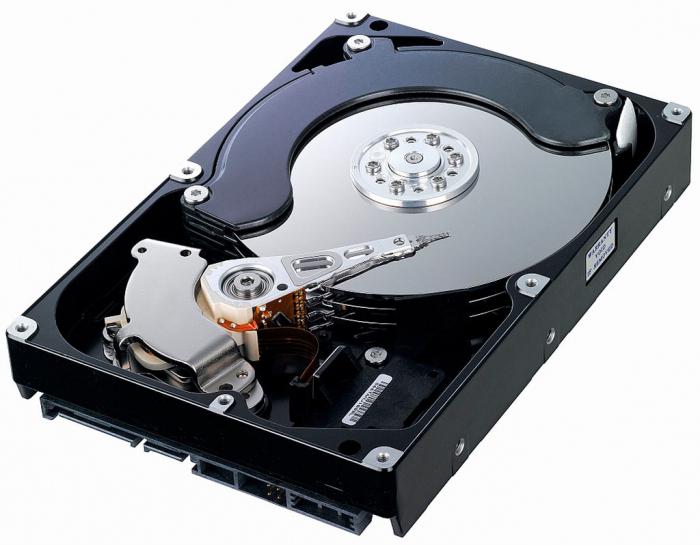

Dyski twarde

Dysk twardy jest również klasycznym komponentem komputera. Należy do kategorii stałego składowania. Typowa dla współczesnej architektury PC. Dyski twarde często przechowują większość plików. Można zauważyć, że ten komponent należy do najmniej wymagających ze względu na specyfikację płyty głównej, procesora, pamięci RAM i karty graficznej. Ale znowu, jeśli dysk twardy charakteryzuje się niską wydajnością, to istnieje możliwość, że komputer będzie działał wolno, nawet jeśli zostaną na nim zainstalowane inne komponenty sprzętowe związane z najbardziej zaawansowanymi technologicznie.

Głównym kryterium wydajności dysku jest szybkość. Objętość jest również ważna, ale znaczenie tego parametru zależy od potrzeb użytkownika. Jeśli na komputerze zainstalowany jest mały dysk twardy o bardzo dużej prędkości obrotowej, komputer będzie działał szybciej niż przy dużej pojemności i niskiej prędkości obrotowej odpowiednich elementów urządzenia.

Płyta główna, procesor, pamięć RAM i karta wideo są wewnętrznymi komponentami komputera. Dysk twardy może być zarówno wewnętrzny, jak i zewnętrzny, w tym przypadku najczęściej wymienny. Głównymi odpowiednikami twardego dysku są pamięci flash, karty pamięci. W niektórych przypadkach można je całkowicie zastąpić, ale w miarę możliwości zaleca się wyposażenie komputera w co najmniej jeden dysk twardy.

Koncepcja otwartej architektury PC nie ogranicza się oczywiście do możliwości zastąpienia i wybrania pięciu wskazanych komponentów. Jest tyle urządzeń do innych celów, które są częścią komputera. Są to napędy DVD i Blue-ray, karty dźwiękowe, drukarki, skanery, modemy, karty sieciowe fanów. Zestaw odpowiednich komponentów może predestynować konkretną markową architekturę komputera. Płyta główna, procesor, pamięć RAM, karta wideo i dysk twardy są elementami, bez których współczesny komputer nie może działać lub jego działanie będzie niezwykle trudne. Określają one głównie szybkość pracy. Dlatego też, po zainstalowaniu na komputerze elementów technologicznych i nowoczesnych odpowiedniego typu, użytkownik będzie mógł złożyć wydajne i wydajne komputery PC.

Komputery Apple

Jakie są inne rodzaje architektury komputerów? Wśród tych, którzy są w bezpośredniej konkurencji z architekturą IBM, całkiem sporo. Na przykład są to komputery Apple Macintosh. Oczywiście według wielu kryteriów są one podobne do architektury IBM - mają też procesor, pamięć, kartę wideo, płytę główną i dyski twarde.

Jednak komputery Apple charakteryzują się tym, że ich platforma jest zamknięta. Użytkownik jest bardzo ograniczony w instalowaniu komponentów na komputerze według własnego uznania. Apple jest jedyną marką, która może legalnie produkować komputery w odpowiedniej architekturze. Podobnie Apple jest jedynym dostawcą funkcjonalnych systemów operacyjnych produkowanych pod własną platformą. Tak więc, ten lub inny rodzaj architektury PC może różnić się nie tyle od komponentów sprzętowych komputera, co od podejść producentów do wydania odpowiednich rozwiązań. W zależności od własnej strategii rozwoju firma może skupić się na otwartości lub bliskości platformy.

Tak więc główne cechy architektury współczesnych komputerów na przykładzie platformy IBM: brak monopolowego producenta marek komputerów, otwartość. I zarówno w oprogramowaniu, jak i sprzęcie. Jeśli chodzi o głównego konkurenta platformy IBM, Apple, główne cechy komputera o odpowiedniej architekturze to tajemnica, a także wydanie komputerów przez jedną markę.