Historia rozwoju informatyki od starożytnego świata do IBM

Historia informatyki to historia matematyki i obliczenia algebraiczne. W historii rozwoju jest kilka etapów. Jest to przede wszystkim etap home-mechaniczny, który obejmuje ogólny rozwój mowy ludzkiej, tworzenie pisma jako metody utrwalania i transfer informacji w ludzkich gminach.

Okres krajowy

Historia rozwoju informatyki na tym etapie obejmuje pojawienie się  koncepcje liczb i obliczeń. Tak więc początkowo w starożytnych społeczeństwach Sumeru i Akkadu, później w Chinach, Indiach, Egipcie i wreszcie w starożytnych państwach basenu Morza Śródziemnego pojawiły się coraz bardziej zaawansowane metody liczenia, rejestrowania liczb i obliczeń astronomicznych. W Czechach archeolodzy odkryli tak zwaną "kość Westonica", która jest kością z karbami używanymi do liczenia. Według naukowców ten artefakt ma około trzydziestu tysięcy lat. W Chinach ponad pięć tysięcy lat temu stworzono konta dotyczące kości znane wszystkim i dzisiaj, aby ułatwić operacje liczenia. W starożytnej cywilizacji powstał raczej doskonały system rachunku różniczkowego, znany dziś jako rzymski. Wszystko to jest także historią rozwoju informatyki, ponieważ stała się podstawą ludzkiej wiedzy dla najnowocześniejszych systemów komputerowych.

koncepcje liczb i obliczeń. Tak więc początkowo w starożytnych społeczeństwach Sumeru i Akkadu, później w Chinach, Indiach, Egipcie i wreszcie w starożytnych państwach basenu Morza Śródziemnego pojawiły się coraz bardziej zaawansowane metody liczenia, rejestrowania liczb i obliczeń astronomicznych. W Czechach archeolodzy odkryli tak zwaną "kość Westonica", która jest kością z karbami używanymi do liczenia. Według naukowców ten artefakt ma około trzydziestu tysięcy lat. W Chinach ponad pięć tysięcy lat temu stworzono konta dotyczące kości znane wszystkim i dzisiaj, aby ułatwić operacje liczenia. W starożytnej cywilizacji powstał raczej doskonały system rachunku różniczkowego, znany dziś jako rzymski. Wszystko to jest także historią rozwoju informatyki, ponieważ stała się podstawą ludzkiej wiedzy dla najnowocześniejszych systemów komputerowych.

Okres mechaniczny

Kolejny etap związany jest z próbami zmechanizowania procesu obliczeniowego. Pojawiają się w epoce humanizmu i renesansu. W 1642 r. Słynny fizyk Blaise Pascal stworzył pierwsze urządzenie na świecie, które mechanicznie wykonywało operacje odejmowania i dodawania. Trzy dekady później Gottfried Leibniz, na podstawie maszyny Pascala, stworzył maszynę dodającą, która mogła wykonywać mnożenie i dzielenie. Nawiasem mówiąc, ten mechanizm był używany aż do połowy XX wieku. Stopniowo tworzyły podobne i bardziej wyrafinowane mechanizmy.

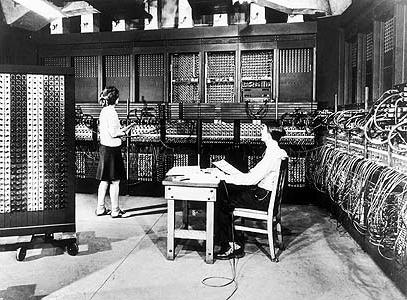

Elektroniczny okres obliczeniowy

Nowy przełom w historii rozwoju informatyki występuje już na przełomie XIX i XX wieku na tle ogólnego rozwoju technologii. W 1930 roku Alan Turing z Uniwersytetu w Cambridge dosłownie stworzył prototyp nowoczesnego komputera, publikując swoją wizję takiej maszyny w artykule "Na liczbach obliczanych". Po trzynastu latach pracownik IBM, Howard Aiken, zdołał stworzyć pierwszy komputer elektroniczny, który w cztery sekundy poradził sobie z dwudziestoma trzema cyframi. W 1945 r. Matematyk John von Neumann zaproponował architektoniczną wizję tego, na czym powinny składać się komponenty komputera: arytmetyczna jednostka logiczna, urządzenie pamięci, urządzenie sterujące, zewnętrzne urządzenia do dostarczania i odbierania informacji z komputera ze świata zewnętrznego. Zasada ta została przyjęta i jest stosowana do dziś bez większych zmian. Później komputery intensywnie rozwijały się w ewolucyjny sposób. Tak więc, na przełomie lat 50. i 60. XX wieku, zamiast lamp, komputery pojawiły się na tranzystorach, aw połowie lat 60. na małych układach scalonych. Już na początku lat 70. zastąpiono je dużymi układami scalonymi, które są nadal używane do dziś.

Nowy przełom w historii rozwoju informatyki występuje już na przełomie XIX i XX wieku na tle ogólnego rozwoju technologii. W 1930 roku Alan Turing z Uniwersytetu w Cambridge dosłownie stworzył prototyp nowoczesnego komputera, publikując swoją wizję takiej maszyny w artykule "Na liczbach obliczanych". Po trzynastu latach pracownik IBM, Howard Aiken, zdołał stworzyć pierwszy komputer elektroniczny, który w cztery sekundy poradził sobie z dwudziestoma trzema cyframi. W 1945 r. Matematyk John von Neumann zaproponował architektoniczną wizję tego, na czym powinny składać się komponenty komputera: arytmetyczna jednostka logiczna, urządzenie pamięci, urządzenie sterujące, zewnętrzne urządzenia do dostarczania i odbierania informacji z komputera ze świata zewnętrznego. Zasada ta została przyjęta i jest stosowana do dziś bez większych zmian. Później komputery intensywnie rozwijały się w ewolucyjny sposób. Tak więc, na przełomie lat 50. i 60. XX wieku, zamiast lamp, komputery pojawiły się na tranzystorach, aw połowie lat 60. na małych układach scalonych. Już na początku lat 70. zastąpiono je dużymi układami scalonymi, które są nadal używane do dziś.

Nowoczesność

Nowoczesność

W 1978 roku informatyka została uznana za oficjalną naukę, która bada dziedziny związane z tworzeniem, wdrażaniem i przetwarzanie informacji za pośrednictwem technologii komputerowej i ich oprogramowania. Dzisiaj nauka, którą nazywamy informatyką, stała się szeroko znana w świecie zachodnim pod nazwą "informatyka". Dziś historia rozwoju systemów informatycznych przeżywa być może najbardziej intensywną fazę. Dosłownie co roku daje nam radykalnie nowe technologie. I można się zastanawiać, jak bardzo znaczący postęp został dokonany dzisiaj, patrząc przynajmniej w ostatniej dekadzie.