Historia rozwoju informatyki. Krajowa technologia komputerowa. Pierwszy komputer

Gdy tylko osoba odkryła pojęcie "ilości", natychmiast zaczął wybierać narzędzia, które optymalizują i ułatwiają rachunek. Dzisiaj komputery o dużej mocy obliczeniowej oparte na zasadach obliczeń matematycznych, przetwarzają, przechowują i przesyłają informacje - najważniejszy zasób i motor ludzkiego postępu. Nietrudno zorientować się, w jaki sposób nastąpił rozwój technologii komputerowej, po krótkiej analizie głównych etapów tego procesu.

Główne etapy rozwoju informatyki

Najpopularniejsza klasyfikacja proponuje naświetlać główne etapy rozwoju technologii komputerowej w układzie chronologicznym:

- Etap ręczny. Zaczęło się u zarania epoki ludzkiej i trwało do połowy XVII wieku. W tym okresie podstawy konta. Później, wraz z tworzeniem układów liczb pozycyjnych, pojawiły się urządzenia (wyniki, liczydło, później - zasada suwaka), umożliwiając obliczenia przez wyładowania.

- Etap mechaniczny. Zaczęło się w połowie XVII wieku i trwało prawie do końca XIX wieku. Poziom rozwoju nauki w tym okresie umożliwił stworzenie urządzeń mechanicznych wykonujących podstawowe operacje arytmetyczne i automatycznie zapamiętujących wyższe cyfry.

- Etap elektromechaniczny jest najkrótszy ze wszystkich, co łączy w sobie historię rozwoju technologii komputerowej. Trwało to tylko około 60 lat. Jest to luka między wynalazkiem w 1887 r. Pierwszego tabulatora do 1946 r., Kiedy pojawił się pierwszy komputer (ENIAC). Nowe maszyny, których działanie opierało się na napędzie elektrycznym i przekaźniku elektrycznym, umożliwiły wykonywanie obliczeń z dużo większą szybkością i dokładnością, ale proces liczenia wciąż musiał być kontrolowany przez człowieka.

- Faza elektroniczna rozpoczęła się w drugiej połowie ubiegłego wieku i trwa do dzisiaj. Jest to historia sześciu generacji komputerów elektronicznych - od pierwszych gigantycznych jednostek, które opierały się na lampach elektronicznych, do superwydajnych nowoczesnych superkomputerów z ogromną liczbą procesorów równoległych, które mogą jednocześnie wykonywać wiele poleceń.

Etapy rozwoju technologii komputerowej dzieli się według zasady chronologicznej raczej arbitralnie. W czasach, gdy używane były pewne typy komputerów, aktywnie tworzono warunki wstępne powstania następujących elementów.

Pierwsze urządzenia na koncie

Najwcześniejsze narzędzie liczące, które zna historię rozwoju technologii komputerowej, to dziesięć palców u rąk danej osoby. Wyniki rachunku rejestrowano początkowo za pomocą palców, nacięć na drewnie i kamieniu, specjalnych patyczków, sęków.

Wraz z nadejściem pisania pojawiły się i rozwijały różne sposoby pisania liczb, wynaleziono układy liczb pozycyjnych (dziesiętny w Indiach, szesnastkowy w Babilonie).

Od około 4 wieku pne starożytni Grecy zaczęli przechodzić przez liczydło. Początkowo była to gliniana płaska płyta z paskami na niej ostrym przedmiotem. Rachunek został przeprowadzony poprzez umieszczenie na tych paskach w określonej kolejności małych kamieni lub innych drobnych przedmiotów.

W Chinach w IV wieku ne pojawiło się siedem akcentów - suanpan (suanpan). Na prostokątnej drewnianej ramie rozciągają się druty lub liny - od dziewięciu lub więcej. Inny drut (lina), rozciągnięty prostopadle do reszty, podzielił suanpan na dwie nierówne części. W większym przedziale, zwanym "ziemią", pięć drutów nawleczono na drutach, w mniejszym - "niebie" - było ich dwóch. Każda z opóźnień odpowiadała miejscu dziesiętnemu.

Tradycyjne konta soroban stały się popularne w Japonii od XVI wieku, gdy dotarły tam z Chin. W tym samym czasie pojawiły się rachunki w Rosji.

W XVII wieku, na podstawie logarytmu odkrytego przez szkockiego matematyka Johna Napiera, Anglik Edmond Gunter wymyślił suwak logarytmiczny. To urządzenie jest stale ulepszane i żywe do dnia dzisiejszego. Pozwala na pomnożenie i dzielenie liczb, podnoszenie mocy, definiowanie logarytmów i funkcji trygonometrycznych.

Zasada suwaka stała się urządzeniem, które dopełnia rozwój sprzętu komputerowego na etapie manualnym (mechanika domowa).

Pierwsze mechaniczne urządzenia liczące

W 1623 roku pierwszy mechaniczny "kalkulator" został stworzony przez niemieckiego naukowca Wilhelma Schickarda, który nazwał zegar liczący. Mechanizm tego urządzenia przypominał zwykły zegar, składający się z kół zębatych i gwiazd. Jednak o tym wynalazku dowiedział się dopiero w połowie ubiegłego wieku.

Jakościowym skokiem w dziedzinie technologii komputerowej był wynalazek sumatora Pascaline w 1642. Jego twórca, francuski matematyk Blaise Pascal, rozpoczął pracę nad tym urządzeniem, gdy miał zaledwie 20 lat. "Pascalina" była urządzeniem mechanicznym w postaci skrzynki z dużą liczbą połączonych ze sobą przekładni. Numery, które musiały zostać dodane, zostały wprowadzone do maszyny przez obrócenie specjalnych kół.

W 1673 r. Saski matematyk i filozof Gottfried von Leibniz wynalazł maszynę, która wykonała cztery podstawowe operacje matematyczne i była w stanie wydobyć pierwiastek kwadratowy. Zasada jego pracy została oparta na dwójkowy system liczbowy specjalnie wynaleziony przez naukowców.

W 1818 r. Francuz Charles (Karl) Xavier Thomas de Colmar, oparty na ideach Leibniza, wynalazł maszynę dodającą, która może się rozmnażać i dzielić. Dwa lata później Anglik Charles Babbage postanowił zaprojektować maszynę, która byłaby w stanie wykonywać obliczenia z dokładnością do 20 miejsc po przecinku. Projekt ten pozostał niedokończony, ale w 1830 roku jego autor opracował kolejną - maszynę analityczną do wykonywania dokładnych obliczeń naukowych i technicznych. Maszyna miała być kontrolowana przez oprogramowanie, a do wprowadzania i wyprowadzania informacji należało użyć kart perforowanych z różnymi układami otworów. Projekt Babbage przewidywał opracowanie elektronicznego sprzętu komputerowego i zadań, które można rozwiązać za jego pomocą.

Warto zauważyć, że chwała pierwszego programisty na świecie należy do kobiety - Lady Ade Lovelace (z domu Byron). To ona stworzyła pierwsze programy dla komputera Babbage. Jej imię zostało później nazwane jednym z języków komputerowych.

Opracowanie pierwszych analogów komputerowych

W 1887 r. Rozpoczęła się historia rozwoju technologii komputerowej. Amerykański inżynier Hermann Hollerith (Hollerith) zdołał skonstruować pierwszą elektromechaniczną maszynę obliczeniową - tabulator. W jego mechanizmie był przekaźnik, a także liczniki i specjalne pudełko do sortowania. Urządzenie odczytuje i sortuje zapisy statystyczne wykonane na kartach dziurkowanych. W przyszłości firma założona przez Goldlert stała się trzonem światowej sławy giganta komputerowego IBM.

W 1930 roku amerykański Vannovar Bush stworzył analizator różnicowy. Był zasilany energią elektryczną, a do przechowywania danych wykorzystywano lampy elektronowe. Maszyna ta była w stanie szybko znaleźć rozwiązania złożonych problemów matematycznych.

Sześć lat później brytyjski naukowiec Alan Turing opracował koncepcję maszyny, która stała się teoretyczną podstawą dzisiejszych komputerów. Posiadała wszystkie główne właściwości nowoczesnej technologii komputerowej: mogła krok po kroku wykonywać operacje zaprogramowane w pamięci wewnętrznej.

Rok później George Stibits, naukowiec ze Stanów Zjednoczonych, wynalazł pierwsze elektromechaniczne urządzenie tego kraju zdolne do binarnego dodawania. Jego działania opierały się na algebrze Boole'a - logice matematycznej, stworzonej w połowie XIX wieku przez George'a Boole'a: za pomocą operatorów logicznych AND, OR i NOT. Później sumator binarny stanie się integralną częścią komputera cyfrowego.

W 1938 r. Claude Shannon, pracownik University of Massachusetts, przedstawił zasady działania urządzenia logicznego komputera używającego obwodów elektrycznych do rozwiązywania problemów algebry Boole'a.

Początek ery komputerów

Rządy państw uczestniczących w II wojnie światowej były świadome strategicznej roli komputerów w prowadzeniu działań wojennych. Był to impuls do rozwoju i równoległego pojawiania się w tych krajach komputerów pierwszej generacji.

Pionierem w dziedzinie inżynierii komputerowej był Konrad Zuse - niemiecki inżynier. W 1941 roku stworzył pierwszą automatyczną maszynę obliczeniową, kontrolowaną przez program. Maszyna, zwana Z3, została zbudowana na przekaźnikach telefonicznych, programy do niej zakodowane na perforowanej taśmie. To urządzenie mogło pracować w systemie dwójkowym, a także działać z liczbami zmiennoprzecinkowymi.

Następujący naprawdę model Zuse, Z4, został oficjalnie uznany za pierwszy naprawdę działający programowalny komputer. Przeszedł także do historii jako twórca pierwszego języka programowania wysokiego poziomu o nazwie Plankalcule.

W 1942 roku amerykańscy naukowcy John Atanasov (Atanasoff) i Clifford Berry stworzyli urządzenie komputerowe pracujące na lampach próżniowych. Maszyna wykorzystała również kod binarny, może wykonać serię operacji logicznych.

W 1943 r. W laboratorium rządu angielskiego, w tajemnicy, zbudowano pierwszy komputer, nazywany Kolosem. Zamiast przekaźników elektromechanicznych wykorzystano 2 tysiące lamp elektronowych do przechowywania i przetwarzanie informacji. Był przeznaczony do hakowania i deszyfrowania kodu tajnych wiadomości transmitowanych przez niemiecki szyfrer Enigma, który był szeroko stosowany przez Wehrmacht. Istnienie tego urządzenia przez długi czas trzymane w ścisłej tajemnicy. Po zakończeniu wojny rozkaz zniszczenia został osobiście podpisany przez Winstona Churchilla.

Rozwój architektury

W 1945 r. Amerykański matematyk pochodzenia węgiersko-niemieckiego, Jan (Janos Lajos), von Neumann, stworzył prototyp architektury współczesnych komputerów. Zaproponował napisanie programu w postaci kodu bezpośrednio do pamięci maszyny, co oznaczało wspólne przechowywanie programów i danych w pamięci komputera.

Architektura von Neumanna położyła podwaliny pod pierwszy w Stanach Zjednoczonych uniwersalny elektroniczny komputer ENIAC. Ten olbrzym ważył około 30 ton i znajdował się na powierzchni 170 metrów kwadratowych. W działanie maszyny zaangażowało się 18 tysięcy lamp. Ten komputer może wykonać 300 operacji mnożenia lub 5 tysięcy dodatków w ciągu jednej sekundy.

Pierwszy uniwersalny programowalny komputer w Europie powstał w 1950 roku w Związku Radzieckim (Ukraina). Grupa naukowców z Kijowa, kierowana przez Siergieja Aleksiejewicza Lebiediewa, zaprojektowała małą elektroniczną maszynę liczącą (MESM). Jego prędkość wynosiła 50 operacji na sekundę, zawierała około 6 tysięcy lamp próżniowych.

W 1952 roku BESM, duża elektroniczna maszyna licząca, opracowana również pod kierownictwem Lebiediewa, została uzupełniona o krajowy sprzęt komputerowy. Ten komputer, który wykonał 10 tysięcy operacji na sekundę, był w tym czasie najszybszy w Europie. Informacja została wprowadzona do pamięci maszyny za pomocą taśmy perforowanej, dane zostały wyprowadzone za pomocą drukowania zdjęć.

W tym samym okresie w ZSRR wyprodukowano serię dużych komputerów pod ogólną nazwą Strela (opracowany przez Jurija Jakowlewa Bazilevskiego). Od 1954 roku w Penza rozpoczęła się masowa produkcja uniwersalnego komputera "Ural" pod przywództwem Bashira Rameyeva. Najnowsze modele były kompatybilne ze sobą sprzętowo i programowo, istniał szeroki wybór urządzeń peryferyjnych, umożliwiających montaż maszyn o różnych konfiguracjach.

Tranzystory. Wydanie pierwszych komputerów szeregowych

Jednak lampy bardzo szybko zawiodły, bardzo trudno pracować z maszyną. Tranzystor, wynaleziony w 1947 roku, był w stanie rozwiązać ten problem. Używając właściwości elektrycznych półprzewodników, wykonał te same zadania, co lampy elektronowe, ale zajmował znacznie mniejszą objętość i zużywał nie tyle energii. Wraz z pojawieniem się rdzeni ferrytowych do organizowania pamięci komputera, zastosowanie tranzystorów umożliwiło znaczne zmniejszenie rozmiarów maszyn, czyniąc je bardziej niezawodnymi i szybszymi.

W 1954 roku amerykańska firma "Texas Instruments" zaczęła produkować tranzystory w seriach, a dwa lata później w Massachusetts pojawił się pierwszy komputer tranzystorowy drugiej generacji - TX-O.

W połowie ubiegłego stulecia znaczna część organizacji państwowych i dużych firm używała komputerów do obliczeń naukowych, finansowych, inżynieryjnych, pracy z dużymi tablicami danych. Stopniowo komputery zdobywały funkcje znane nam dzisiaj. W tym czasie pojawiły się plotery, drukarki, nośniki pamięci na dyskach magnetycznych i taśmie.

Aktywne wykorzystanie technologii komputerowej doprowadziło do rozszerzenia obszarów zastosowań i wymagało stworzenia nowych technologii oprogramowania. Opublikowano języki programowania wysokiego poziomu pozwala przenosić programy z jednego komputera na drugi i upraszczać proces pisania kodu ("Fortran", "Cobol" i inne). Pojawiły się specjalne programy tłumaczące, które zamieniają kod z tych języków na polecenia, które są bezpośrednio postrzegane przez maszynę.

Wygląd układów scalonych

W latach 1958-1960, dzięki inżynierom ze Stanów Zjednoczonych, Robertowi Noyce'owi i Jackowi Kilby, świat dowiedział się o istnieniu układów scalonych. Na podstawie miniaturowych tranzystorów krzemowych i niemetalowych osadzonych na kryształach i innych elementów, czasem nawet setek i tysięcy. Chipsy mierzące nieco ponad centymetr pracowały znacznie szybciej niż tranzystory i zużywały znacznie mniej energii. Wraz z ich pojawieniem się, historia rozwoju technologii komputerowej łączy pojawienie się trzeciej generacji komputerów.

W 1964 roku IBM wypuścił pierwszy komputer z rodziny SYSTEM 360, oparty na układach scalonych. Od tego czasu można śledzić masową produkcję komputerów. Wyprodukowano ponad 20 tysięcy kopii tego komputera.

W 1972 r. W ZSRR opracowano komputer typu EU (single series). Były to standaryzowane kompleksy do pracy centrów komputerowych, które miały wspólny system poleceń. Podstawę podjął amerykański system IBM 360.

W następnym roku DEC wydał mini-komputer PDP-8, który stał się pierwszym komercyjnym projektem w tej dziedzinie. Stosunkowo niski koszt minikomputerów umożliwił małym firmom korzystanie z nich.

W tym samym okresie oprogramowanie było stale ulepszane. Opracowano systemy operacyjne zaprojektowane w celu utrzymania maksymalnej liczby urządzeń zewnętrznych, pojawiły się nowe programy. W 1964 roku opracowano BASIC - język zaprojektowany specjalnie do szkolenia początkujących programistów. Pięć lat później pojawił się Pascal, który okazał się bardzo wygodny w rozwiązywaniu różnorodnych problemów.

Komputery osobiste

Po 1970 rozpoczęło się wydanie czwartego generowanie komputera. Rozwój technologii komputerowej w tym czasie charakteryzuje się wprowadzeniem dużych układów scalonych do produkcji komputerów. Takie maszyny mogłyby teraz wykonywać w jednej sekundzie tysiące milionów operacji obliczeniowych, a pojemność ich pamięci RAM wzrosła do 500 milionów bitów binarnych. Znaczna redukcja kosztów mikrokomputerów doprowadziła do tego, że możliwość ich zakupu stopniowo pojawiała się w zwykłej osobie.

Jednym z pierwszych producentów komputerów osobistych był Apple. Steve Jobs i Steve Wozniak, którzy go stworzyli, zaprojektowali pierwszy model PC w 1976 roku, nadając mu nazwę Apple I. Kosztowało to tylko 500 USD. Rok później zaprezentowano następujący model tej firmy - Apple II.

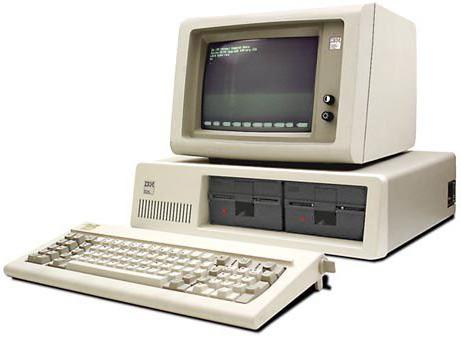

Komputer tego czasu po raz pierwszy stał się podobny do domowego urządzenia: oprócz kompaktowych rozmiarów miał elegancki wygląd i przyjazny dla użytkownika interfejs. Rozprzestrzenianie się komputerów osobistych pod koniec lat 70. doprowadziło do zauważalnego spadku popytu na duże komputery. Fakt ten poważnie dotyczył ich producenta, IBM, aw 1979 roku uruchomił swój pierwszy komputer.

Dwa lata później pojawił się pierwszy mikrokomputer tej firmy o otwartej architekturze, oparty na 16-bitowym mikroprocesorze 8088 firmy Intel. Komputer został uzupełniony o monochromatyczny wyświetlacz, dwa napędy dyskietek na pięciocalowe dyskietki i 64-kilobajtową pamięć RAM. W imieniu firmy twórczej Microsoft opracował specjalny system operacyjny dla tego komputera. Na rynku pojawiły się liczne klony komputera IBM PC, które przyspieszyły rozwój przemysłowej produkcji komputerów osobistych.

W 1984 roku firma Apple opracowała i wypuściła nowy komputer Macintosh. Jego system operacyjny był wyjątkowo przyjazny dla użytkownika: reprezentował polecenia w postaci graficznych obrazów i pozwalał na wjazd do nich za pomocą manipulatora - myszy. Dzięki temu komputer stał się jeszcze bardziej dostępny, ponieważ teraz nie wymagało od użytkownika specjalnych umiejętności.

Komputery piątej generacji technologii komputerowych niektóre źródła pochodzą z lat 1992-2013. W skrócie, ich podstawowa koncepcja jest sformułowana w następujący sposób: są to komputery tworzone na bazie mikroprocesorów superkompleksu, mające strukturę równoległobokową, co umożliwia jednoczesne wykonywanie dziesiątek kolejnych poleceń osadzonych w programie. Maszyny z kilkuset procesorami działającymi równolegle umożliwiają dokładniejsze i szybsze przetwarzanie danych, a także tworzenie sprawnie działających sieci.

Rozwój nowoczesnej technologii komputerowej pozwala nam mówić o komputerach szóstej generacji. Są to komputery elektroniczne i optoelektroniczne działające na dziesiątkach tysięcy mikroprocesorów, charakteryzujących się masywną równoległością i symulacją architektury neuronowych systemów biologicznych, co pozwala im z powodzeniem rozpoznawać złożone obrazy.

Konsekwentnie analizując wszystkie etapy rozwoju technologii komputerowej, należy zauważyć interesujący fakt: wynalazki, które sprawdziły się dobrze w każdym z nich przetrwały do dnia dzisiejszego i nadal są z powodzeniem stosowane.

Klasy komputerowe

Istnieją różne opcje klasyfikacji komputerów.

Więc celowo komputery są podzielone:

- dla uniwersalnych - tych, które są w stanie rozwiązywać najróżniejsze zadania matematyczne, ekonomiczne, inżynieryjne, naukowe i inne;

- zorientowany na problem - rozwiązywanie problemów węższego kierunku, związanych, z reguły, z zarządzaniem określonymi procesami (rejestracja danych, gromadzenie i przetwarzanie niewielkich ilości informacji, wykonywanie obliczeń zgodnie z prostymi algorytmami). Mają bardziej ograniczone zasoby oprogramowania i sprzętu niż pierwsza grupa komputerów;

- Wyspecjalizowane komputery z reguły rozwiązują ściśle określone zadania. Mają wysoce wyspecjalizowaną strukturę i przy stosunkowo niewielkiej złożoności urządzenia i kontroli są dość niezawodne i produktywne w swojej dziedzinie. Są to na przykład kontrolery lub adaptery sterujące wieloma urządzeniami, a także programowalne mikroprocesory.

Pod względem wielkości i wydajności nowoczesna elektroniczna technologia komputerowa dzieli się na:

- na super-dużych (superkomputerach);

- duże komputery;

- małe komputery;

- ultra małe (mikrokomputery).

W ten sposób zauważyliśmy, że urządzenia, opracowane najpierw przez człowieka w celu rozliczania zasobów i wartości, a następnie - do szybkiego i dokładnego wykonywania złożonych obliczeń i operacji obliczeniowych, były stale rozwijane i ulepszane.